Co jsou tréninková data ve strojovém učení:

Definice, výhody, výzvy, příklady a datové sady

Průvodce konečnými kupujícími 2024

Úvod

Ve světě umělé inteligence a strojového učení je trénink dat nevyhnutelný. Díky tomu jsou moduly strojového učení přesné, efektivní a plně funkční. V tomto příspěvku podrobně prozkoumáme, co jsou data školení AI, kvalita dat školení, sběr dat a licencování a další.

Odhaduje se, že dospělý se v průměru rozhoduje o životě a každodenních věcech na základě minulého učení. Ty zase pocházejí ze životních zkušeností utvářených situacemi a lidmi. V doslovném smyslu nejsou situace, instance a lidé ničím jiným než daty, která se dostávají do naší mysli. Jak shromažďujeme roky dat ve formě zkušeností, lidská mysl má tendenci dělat bezproblémová rozhodnutí.

Co to sděluje? Tato data jsou při učení nevyhnutelná.

Podobně jako dítě potřebuje nálepku zvanou abeceda, aby porozumělo písmenům A, B, C, D, potřebuje také stroj porozumět datům, která přijímá.

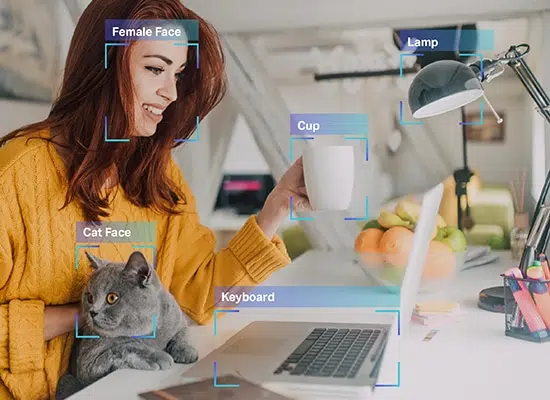

To je přesně to, co Artificial Intelligence (AI) školení je o. Stroj se neliší od dítěte, které se ještě musí naučit věci z toho, co se mají učit. Stroj neví rozlišovat mezi kočkou a psem nebo autobusem a autem, protože tyto položky ještě nezažili nebo se nenaučili, jak vypadají.

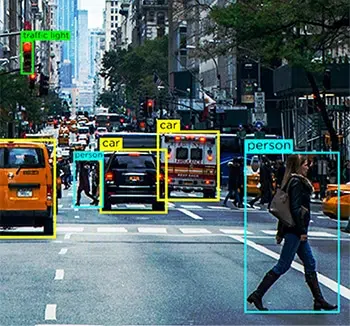

Takže pro někoho, kdo vyrábí auto s vlastním pohonem, je primární funkcí, kterou je třeba přidat, schopnost systému porozumět všem každodenním prvkům, s nimiž se auto může setkat, aby je vozidlo mohlo identifikovat a učinit vhodná rozhodnutí o řízení. To je kde AI tréninková data přichází do hry.

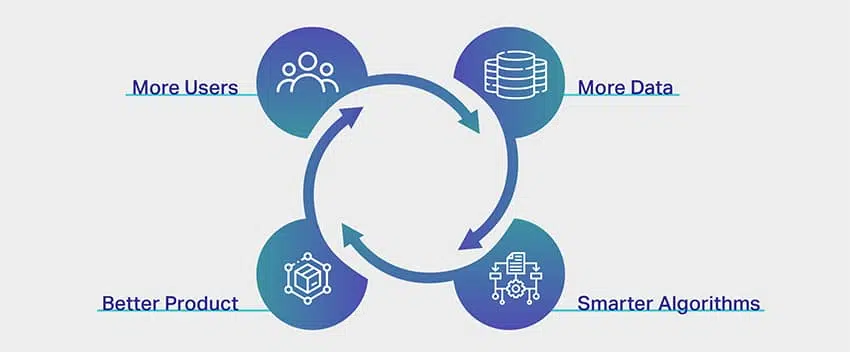

Moduly umělé inteligence nám dnes nabízejí mnoho vymožeností v podobě doporučovacích motorů, navigace, automatizace a dalších. To vše se děje díky tréninku dat AI, který byl použit k trénování algoritmů, když byly vytvořeny.

Data školení o AI jsou základním procesem při budování strojové učení a AI algoritmy. Pokud vyvíjíte aplikaci založenou na těchto technologických konceptech, musíte své systémy naučit rozumět datovým prvkům pro optimalizované zpracování. Bez školení bude váš model AI neefektivní, chybný a potenciálně zbytečný.

Odhaduje se, že Data Scientists utrácejí více než 80% jejich času v přípravě a obohacení dat za účelem trénování modelů ML.

Takže pro ty z vás, kteří chtějí získat financování od rizikových kapitalistů, tamních sóloprenažerů, kteří pracují na ambiciózních projektech, a technologických nadšenců, kteří s pokročilou AI teprve začínají, jsme vyvinuli tuto příručku, která vám pomůže zodpovědět nejdůležitější otázky týkající se vaše tréninková data AI.

Zde prozkoumáme, co jsou data školení AI, proč jsou ve vašem procesu nevyhnutelná, objem a kvalita dat, která skutečně potřebujete, a další.

Co jsou údaje o tréninku AI?

Tréninková data AI jsou pečlivě upravovány a vyčištěny informace, které jsou vkládány do systému pro účely školení. Tento proces dělá nebo narušuje úspěch modelu AI. Může to pomoci při rozvoji pochopení, že ne všechna čtyřnohá zvířata na obrázku jsou psi, nebo by to mohlo pomoci modelu rozlišit mezi vzteklým křikem a radostným smíchem. Je to první fáze při vytváření modulů umělé inteligence, které vyžadují data podávání lžičkou, aby se stroje naučily základy a umožnily jim učit se, když se přidávají další data. To opět vytváří cestu pro efektivní modul, který koncovým uživatelům chrlí přesné výsledky.

Zvažte proces tréninkových dat AI jako trénink pro hudebníka, kde čím více cvičí, tím lepší je ve skladbě nebo stupnici. Jediný rozdíl je v tom, že stroje se také musí nejprve naučit, co je hudební nástroj. Podobně jako u hudebníka, který dobře využívá nespočet hodin strávených cvičením na pódiu, nabízí model umělé inteligence spotřebitelům při nasazení optimální zážitek.

Proč jsou vyžadována data o školení AI?

Nejjednodušší odpovědí na to, proč jsou pro vývoj modelu vyžadována tréninková data AI, je, že bez nich by stroje vůbec nevěděly, co mají pochopit. Stejně jako jednotlivec vyškolený pro svou konkrétní práci potřebuje stroj soubor informací, aby sloužil určitému účelu a poskytoval také odpovídající výsledky.

Zvažme znovu příklad autonomních automobilů. Terabajty po terabajtech dat v samořídícím vozidle pocházejí z více senzorů, zařízení pro počítačové vidění, RADAR, LIDAR a mnohem více. Všechny tyto obrovské kousky dat by byly zbytečné, pokud by systém centrálního zpracování automobilu neví, co s tím má dělat.

Například, počítačového vidění jednotka vozu mohla chrlit objemy dat o silničních prvcích, jako jsou chodci, zvířata, výmoly a další. Pokud by modul strojového učení nebyl proškolen na jejich identifikaci, vozidlo by nevědělo, že jde o překážky, které by mohly při nehodě způsobit nehodu. Proto musí být moduly vyškoleny v tom, co je každý jednotlivý prvek na silnici a jak jsou pro každý z nich vyžadována různá rozhodnutí o řízení.

I když je to jen pro vizuální prvky, vůz by měl být schopen porozumět i lidským instrukcím Zpracování přirozeného jazyka (NLP) a sbírka zvuku nebo řeči a odpovídajícím způsobem reagovat. Například pokud řidič nařídí informačnímu a zábavnímu systému ve vozidle, aby vyhledal blízké čerpací stanice, měl by být schopen pochopit tento požadavek a dosáhnout příslušných výsledků. K tomu by však měl být schopen porozumět každému slovu ve frázi, spojit je a být schopen porozumět otázce.

I když by vás mohlo zajímat, zda je proces tréninkových dat AI složitý pouze proto, že jsou nasazeny pro těžké případy použití, jako je autonomní automobil, faktem je, že i další film, který Netflix doporučuje, prochází stejným procesem, aby vám nabídl osobní návrhy. Jakákoli aplikace, platforma nebo entita, která má přidruženou AI, je ve výchozím nastavení napájena tréninkovými daty AI.

Jaké typy dat potřebuji?

K efektivnímu trénování modelů strojového učení jsou zapotřebí 4 primární typy dat, tj. Obrázky, video, zvuk/řeč nebo text. Typ potřebných údajů by závisel na řadě faktorů, jako je například případ použití, složitost modelů, které se mají školit, použitá metoda školení a rozmanitost požadovaných vstupních údajů.

Kolik dat je adekvátní?

Říkají, že učení nemá konce a tato fráze je ideální v datovém spektru tréninku AI. Čím více dat, tím lepší výsledky. Tak neurčitá odpověď však nestačí k tomu, aby přesvědčila každého, kdo hledá spuštění aplikace využívající umělou inteligenci. Realita je však taková, že neexistuje žádné obecné pravidlo, vzorec, index nebo měření přesného objemu dat, které je třeba k trénování jejich datových sad AI.

Expert na strojové učení by komicky odhalil, že pro odvození objemu dat požadovaných pro projekt je třeba vytvořit samostatný algoritmus nebo modul. To je bohužel také realita.

Nyní existuje důvod, proč je extrémně obtížné omezit objem dat potřebných pro výcvik AI. Důvodem je složitost samotného procesu školení. Modul AI obsahuje několik vrstev vzájemně propojených a překrývajících se fragmentů, které navzájem ovlivňují a doplňují procesy.

Uvažujme například, že vyvíjíte jednoduchou aplikaci pro rozpoznávání kokosové palmy. Z pohledu to zní celkem jednoduše, že? Z pohledu AI je to však mnohem složitější.

Na samém začátku je stroj prázdný. Neví, co je strom na prvním místě, natož vysoký, pro region specifický, strom s tropickým ovocem. K tomu je třeba model vycvičit v tom, co je to strom, jak se odlišit od ostatních vysokých a štíhlých předmětů, které se mohou objevit v rámečku jako pouliční osvětlení nebo elektrické sloupy, a poté přejít k naučení nuancí kokosového stromu. Jakmile modul strojového učení zjistí, co je to kokosový strom, dalo by se bezpečně předpokládat, že ho umí poznat.

Ale až když nakrmíte obrázek banyánu, uvědomíte si, že systém nesprávně identifikoval banyán pro kokosový strom. Pro systém je cokoli, co je vysoké se seskupenými listy, kokosový strom. Aby to bylo možné eliminovat, musí systém nyní porozumět každému jednotlivému stromu, který není kokosovým stromem, aby ho přesně identifikoval. Pokud se jedná o postup pro jednoduchou jednosměrnou aplikaci s jediným výsledkem, můžeme si jen představit složitost aplikací, které jsou vyvíjeny pro zdravotnictví, finance a další.

Kromě toho to také ovlivňuje množství požadovaných dat školení zahrnuje níže uvedené aspekty:

- Metoda školení, kde jsou rozdíly v datových typech (strukturované a nestrukturované) ovlivňují potřebu objemů dat

- Označování dat nebo anotační techniky

- Způsob přenosu dat do systému

- Poměr tolerance chyb, což jednoduše znamená procento chyby, které jsou ve vašem výklenku nebo doméně zanedbatelné

Reálné příklady tréninkových svazků

I když množství dat, které potřebujete k trénování svých modulů, závisí o vašem projektu a dalších faktorech, o kterých jsme dříve hovořili inspirace nebo reference by pomohly získat rozsáhlou představu o datech požadavky.

Následuje příklad reálného světa o množství použitých datových sad pro účely školení AI různými společnostmi a podniky.

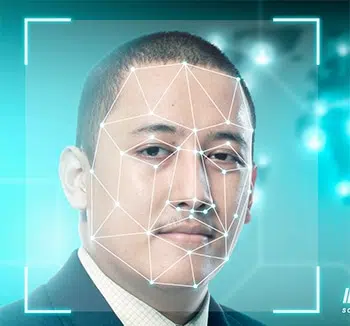

- rozpoznávání obličejů se - velikost vzorku přes 450,000 XNUMX obrázků obličeje

- Obrázek anotace - velikost vzorku přes 185,000 XNUMX obrázků s téměř 650,000 XNUMX anotovaných objektů

- Analýza sentimentu na Facebooku - velikost vzorku přes 9,000 XNUMX komentáře a 62,000 XNUMX příspěvků

- Školení chatbotu - velikost vzorku více než 200,000 XNUMX otázek s více než 2 miliony odpovědí

- Překladová aplikace - velikost vzorku přes 300,000 XNUMX zvuku nebo řeči sbírka od rodilých mluvčích

Co když nemám dostatek dat?

Ve světě AI a ML je datový trénink nevyhnutelný. Správně se říká, že učení novým věcem nemá konce, a to platí, když hovoříme o datovém spektru výcviku AI. Čím více dat, tím lepší výsledky. Existují však případy, kdy se případ použití, který se pokoušíte vyřešit, týká specializované kategorie, a získání správného souboru dat samo o sobě je výzvou. Pokud tedy v tomto scénáři nemáte adekvátní data, předpovědi z modelu ML nemusí být přesné nebo mohou být zkreslené. Existují způsoby, jako je rozšiřování dat a značení dat, které vám mohou pomoci překonat nedostatky, ale výsledek stále nemusí být přesný ani spolehlivý.

Jak vylepšujete kvalitu dat?

Kvalita dat je přímo úměrná kvalitě výstupu. Proto vysoce přesné modely vyžadují pro školení vysoce kvalitní datové sady. Má to však háček. Pro koncept, který je závislý na přesnosti a přesnosti, je koncept kvality často poměrně vágní.

Vysoce kvalitní data zní silně a důvěryhodně, ale co to vlastně znamená?

Co je na prvním místě kvalita?

Stejně jako samotná data, která vkládáme do našich systémů, má kvalita také mnoho faktorů a parametrů. Pokud se obrátíte na odborníky na AI nebo veterány strojového učení, mohou sdílet jakoukoli permutaci vysoce kvalitních dat, ať už je to cokoli -

- Jednotný - data pocházející z jednoho konkrétního zdroje nebo jednotnost v souborech dat, které pocházejí z více zdrojů

- Obsáhlý - data, která pokrývají všechny možné scénáře, na kterých má váš systém pracovat

- Pravidelné - každý bajt dat má podobnou povahu

- Relevantní - data, která zdrojujete a krmíte, jsou podobná vašim požadavkům a očekávaným výsledkům a

- smíšený - máte kombinaci všech typů dat, jako jsou audio, video, obrázky, text a další

Nyní, když chápeme, co znamená kvalita v kvalitě dat, pojďme se rychle podívat na různé způsoby, jak můžeme kvalitu zajistit sběr dat a generace.

1. Podívejte se na strukturovaná a nestrukturovaná data. První jsou snadno srozumitelné pro stroje, protože mají anotované prvky a metadata. Ten je však stále nezpracovaný a neobsahuje žádné cenné informace, kterých by systém mohl využít. Zde přichází na řadu anotace dat.

2. Odstranění předpojatosti je dalším způsobem, jak zajistit kvalitní data, protože systém ze systému odstraní jakékoli předsudky a poskytne objektivní výsledek. Předpojatost pouze zkresluje vaše výsledky a činí je zbytečnými.

3. Důkladně vyčistěte data, protože to vždy zvýší kvalitu vašich výstupů. Každý datový vědec by vám řekl, že hlavní část jejich pracovní role je čištění dat. Při čištění dat odstraňujete duplikáty, šum, chybějící hodnoty, strukturální chyby atd.

Co ovlivňuje kvalitu tréninkových dat?

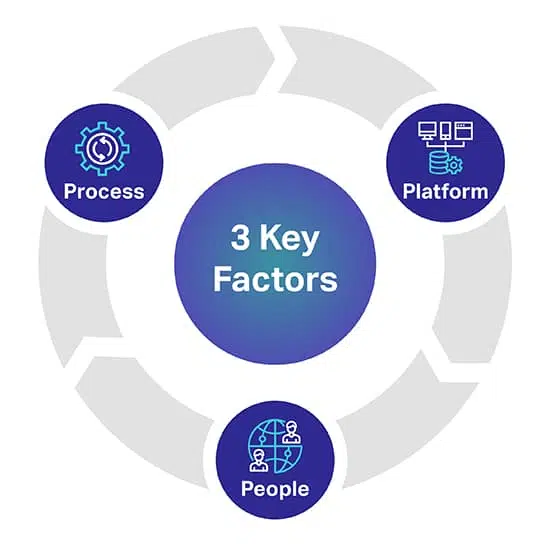

Existují tři hlavní faktory, které vám mohou pomoci předpovědět úroveň kvality, kterou pro své modely AI/ML požadujete. Tři klíčové faktory jsou lidé, proces a platforma, které mohou váš projekt AI rozbít nebo rozbít.

Plošina: K úspěšnému nasazení nejnáročnějších iniciativ AI a ML je zapotřebí kompletní proprietární platforma typu člověk ve smyčce. Platforma je také zodpovědná za správu pracovníků a maximalizaci kvality a propustnosti

lidé: Aby byla AI chytřejší, potřebuje lidi, kteří patří k nejchytřejším lidem v oboru. Abyste mohli škálovat, potřebujete tisíce těchto profesionálů z celého světa k přepisu, označování a komentování všech datových typů.

Process: Poskytování konzistentních, úplných a přesných dat standardu zlata je komplexní práce. Je to však to, co budete vždy potřebovat, abyste dodrželi nejvyšší standardy kvality, stejně jako přísné a osvědčené kontroly kvality a kontrolní body.

Odkud získáváte tréninková data AI?

Na rozdíl od naší předchozí části zde máme velmi přesný přehled. Pro ty z vás, kteří hledají zdrojová data

nebo pokud právě sbíráte video, sbíráte obrázky, sbíráte text a další, existují tři

primární cesty, ze kterých můžete získávat svá data.

Pojďme je prozkoumat jednotlivě.

Zdroje zdarma

Zdarma zdroje jsou cesty, které jsou nedobrovolnými úložišti obrovských objemů dat. Jsou to data, která tam prostě leží na povrchu zdarma. Mezi bezplatné zdroje patří -

- Datové sady Google, kde bylo v roce 250 vydáno více než 2020 milionů souborů dat

- Fóra jako Reddit, Quora a další, která jsou vynalézavým zdrojem dat. Kromě toho vám vědy o datech a komunity umělé inteligence na těchto fórech mohou po oslovení také pomoci s konkrétními soubory dat.

- Kaggle je další bezplatný zdroj, kde kromě bezplatných datových sad najdete zdroje pro strojové učení.

- Také jsme uvedli bezplatné otevřené datové sady, které vám pomohou začít trénovat vaše modely AI

I když jsou tyto cesty zdarma, nakonec byste utratili čas a úsilí. Data z bezplatných zdrojů jsou všude a je třeba věnovat hodiny práce jejich získávání, čištění a přizpůsobení podle vašich potřeb.

Jedním z dalších důležitých ukazatelů k zapamatování je, že některá data z bezplatných zdrojů nelze použít také pro komerční účely. To vyžaduje licencování dat.

Scraping dat

Jak název napovídá, škrábání dat je proces těžby dat z více zdrojů pomocí vhodných nástrojů. Z webů, veřejných portálů, profilů, deníků, dokumentů a dalších nástrojů mohou nástroje vyškrábat data, která potřebujete, a bez problémů je dostat do vaší databáze.

I když to zní jako ideální řešení, škrábání dat je legální pouze pokud jde o osobní použití. Pokud jste společnost, která chce oškrábat data s komerčními ambicemi, bude to složité a dokonce nezákonné. Proto potřebujete právní tým, který se podívá na webové stránky, shodu a podmínky, než budete moci seškrabat data, která potřebujete.

Externí prodejci

Pokud jde o sběr dat pro tréninková data umělé inteligence, nejideálnější možností je outsourcing nebo oslovení externích dodavatelů datových sad. Berou odpovědnost za nalezení datových sad pro vaše požadavky, zatímco vy se můžete soustředit na vytváření vašich modulů. Je to konkrétně z následujících důvodů -

- nemusíte trávit hodiny hledáním datových cest

- neexistuje žádné úsilí, pokud jde o čištění a klasifikaci dat

- dostanete do ruky kvalitní datové soubory, které přesně odškrtnou všechny faktory, o kterých jsme se v minulosti bavili

- můžete získat datové sady přizpůsobené vašim potřebám

- můžete požadovat objem dat, který potřebujete pro svůj projekt a další

- a co je nejdůležitější, také zajišťují, aby jejich sběr dat a samotné údaje byly v souladu s místními regulačními pokyny.

Jediným faktorem, který by se mohl ukázat jako nedostatek v závislosti na vašem rozsahu operací, je to, že outsourcing zahrnuje výdaje. Opět platí, že to nezahrnuje výdaje.

Shaip již je lídrem v oblasti služeb sběru dat a má vlastní úložiště údajů o zdravotní péči a soubory řeči / zvuku, které lze licencovat pro vaše ambiciózní projekty AI.

Otevřené datové sady - používat nebo nepoužívat?

Například existuje datová sada recenzí produktů Amazon, která obsahuje více než 142 milionů uživatelských recenzí od roku 1996 do roku 2014. U obrázků máte vynikající zdroj, jako je Google Open Images, kde můžete získat soubory dat z více než 9 milionů obrázků. Google má také křídlo s názvem Machine Perception, které nabízí téměř 2 miliony zvukových klipů, které trvají deset sekund.

Navzdory dostupnosti těchto zdrojů (a dalších) je důležitým faktorem, který je často přehlížen, podmínky související s jejich využitím. Určitě jsou veřejné, ale mezi porušením a principem fair use existuje tenká hranice. Každý zdroj má své vlastní podmínky a pokud zkoumáte tyto možnosti, doporučujeme opatrnost. Je to proto, že pod záminkou upřednostňování bezplatných cest by vám mohlo nakonec vzniknout soudní spory a související výdaje.

Skutečné náklady na tréninková data AI

Pouze peníze, které utratíte za pořízení dat nebo vlastní generování dat, nejsou tím, co byste měli zvážit. Musíme vzít v úvahu lineární prvky, jako je čas a úsilí vynaložené na vývoj systémů umělé inteligence stát z transakčního pohledu. nedokáže pochválit druhého.

Čas strávený získáváním a anotací dat

Faktory, jako je geografie, demografie trhu a konkurence ve vašem výklenku, brání dostupnosti příslušných datových sad. Čas strávený manuálním vyhledáváním dat ztrácí čas trénováním vašeho systému AI. Jakmile se vám podaří získat data, budete dále zdržovat školení tím, že budete trávit čas anotováním dat, aby váš počítač mohl pochopit, čím jsou krmena.

Cena sběru a anotace dat

Při získávání dat AI je nutné vypočítat režijní náklady (interní sběratelé dat, anotátoři, údržba zařízení, technická infrastruktura, předplatné nástrojů SaaS, vývoj proprietárních aplikací)

Náklady na špatná data

Špatná data mohou stát morálku vašeho firemního týmu, vaši konkurenční výhodu a další hmatatelné důsledky, které zůstanou bez povšimnutí. Špatná data definujeme jako jakýkoli datový soubor, který je nečistý, nezpracovaný, nerelevantní, zastaralý, nepřesný nebo plný pravopisných chyb. Špatná data mohou váš model AI zkazit zavedením zkreslení a poškozováním vašich algoritmů zkreslenými výsledky.

Výdaje na správu

Všechny náklady zahrnující správu vaší organizace nebo podniku, hmotný a nehmotný majetek představují náklady na správu, které jsou často nejdražší.

Co dál po získávání dat?

Jakmile máte datovou sadu v ruce, dalším krokem je její anotace nebo označení. Po všech složitých úkolech máte čistá nezpracovaná data. Zařízení stále nedokáže pochopit data, která máte, protože není anotována. Zde začíná zbývající část skutečné výzvy.

Jak jsme zmínili, stroj potřebuje data ve formátu, kterému rozumí. To je přesně to, co dělá anotace dat. Bere nezpracovaná data a přidává vrstvy štítků a značek, aby pomohl modulu přesně pochopit každý jednotlivý prvek v datech.

Například v textu bude datové značení říkat systému AI gramatickou syntaxi, slovní druhy, předložky, interpunkce, emoce, sentiment a další parametry spojené s porozuměním stroje. Takto chatboti lépe rozumějí lidským rozhovorům a pouze tehdy, když to dokážou, mohou také lépe napodobit lidské interakce prostřednictvím svých odpovědí.

Jakkoli to zní nevyhnutelně, je také extrémně časově náročné a únavné. Bez ohledu na rozsah vaší firmy nebo její ambice je čas potřebný k anotaci dat obrovský.

Je to především proto, že vaše stávající pracovní síla potřebuje věnovat čas mimo svůj každodenní rozvrh anotacím dat, pokud nemáte specialisty na anotaci dat. Musíte tedy svolat členy svého týmu a přidělit to jako další úkol. Čím více se to zpožďuje, tím déle trvá trénování vašich modelů AI.

Ačkoli existují bezplatné nástroje pro anotaci dat, to nezbavuje skutečnost, že tento proces je časově náročný.

To je místo, kde přicházejí dodavatelé anotací dat, jako je Shaip. Přivedou s sebou specializovaný tým specialistů na anotace dat, aby se soustředili pouze na váš projekt. Nabízejí vám řešení tak, jak chcete pro vaše potřeby a požadavky. Kromě toho s nimi můžete nastavit časový rámec a požadovat dokončení práce v dané konkrétní časové ose.

Jednou z hlavních výhod je skutečnost, že se vaši členové interního týmu mohou i nadále soustředit na to, na čem záleží více pro vaše operace a projekt, zatímco odborníci za vás anotují a označují údaje.

Pomocí outsourcingu lze zajistit optimální kvalitu, minimální čas a maximální přesnost.

Balil

To bylo vše o tréninkových datech AI. Od pochopení toho, co jsou data školení, až po zkoumání bezplatných zdrojů a výhod outsourcingu anotací dat, jsme je probrali všechny. Protokoly a zásady jsou v tomto spektru stále odtržené a vždy vám doporučujeme, abyste se pro své potřeby spojili s odborníky na data o školení AI, jako jsme my.

Od získávání zdrojů, deidentifikace až po anotaci dat vám pomůžeme se všemi vašimi potřebami, abyste mohli pracovat pouze na budování své platformy. Rozumíme složitosti související se získáváním dat a označováním. Proto znovu opakujeme, že obtížné úkoly byste mohli nechat na nás a využít našich řešení.

Obraťte se na nás se všemi potřebami vašich anotací dat ještě dnes.

Promluvme si

Často kladené otázky (FAQ)

Chcete -li vytvářet inteligentní systémy, musíte poskytovat vyčištěné, upravené a použitelné informace, které usnadní učení pod dohledem. Označené informace se nazývají tréninková data AI a zahrnují metadata trhu, ML algoritmy a vše, co pomáhá při rozhodování.

Každý stroj poháněný umělou inteligencí má možnosti omezené jeho historickou minulostí. To znamená, že stroj může předvídat požadovaný výsledek pouze tehdy, pokud byl dříve vyškolen se srovnatelnými soubory dat. Údaje o školení pomáhají s tréninkem pod dohledem s objemem přímo úměrným účinnosti a přesnosti modelů AI.

K trénování konkrétních algoritmů strojového učení jsou nutné různé tréninkové datové sady, které pomáhají nastavením poháněným AI přijímat důležitá rozhodnutí s ohledem na souvislosti. Pokud například plánujete přidat do počítače funkci Computer Vision, je třeba modely vyškolit pomocí komentovaných obrázků a dalších datových sad trhu. Podobně pro zdatnost NLP fungují jako tréninková data velké objemy shromažďování řeči.

Neexistuje žádný horní limit objemu tréninkových dat potřebných k trénování kompetentního modelu AI. Čím větší objem dat, tím lepší bude schopnost modelu identifikovat a oddělit prvky, texty a kontexty.

I když je k dispozici mnoho údajů, ne každý kus je vhodný pro tréninkové modely. Aby algoritmus fungoval co nejlépe, potřebujete komplexní, konzistentní a relevantní soubory dat, které jsou rovnoměrně extrahovány, ale přesto dostatečně rozmanité, aby pokryly širokou škálu scénářů. Bez ohledu na data, která plánujete používat, je lepší je pro lepší učení vyčistit a opatřit poznámkami.

Pokud máte na mysli konkrétní model AI, ale tréninková data nejsou dostačující, musíte nejprve odstranit odlehlé hodnoty, spárovat nastavení přenosu a iterativní učení, omezit funkce a nastavit nastavení jako open-source, aby uživatelé mohli přidávat data pro výcvik stroje, postupně, včas. Můžete dokonce sledovat přístupy týkající se rozšiřování dat a učení přenosu, abyste co nejvíce využili omezené datové sady.

Otevřené datové sady lze vždy použít ke shromažďování tréninkových dat. Pokud však hledáte exkluzivitu pro lepší trénink modelů, můžete se spolehnout na externí dodavatele, bezplatné zdroje jako Reddit, Kaggle a další a dokonce i na Scraping Data pro selektivní těžbu přehledů z profilů, portálů a dokumentů. Bez ohledu na přístup je nutné pořizovaná data před použitím naformátovat, zmenšit a vyčistit.